Generative Engine Optimization (GEO) – Analyse und Optimierung von Generative-AI-Traffic

Die Art und Weise, wie Menschen im Internet nach Inhalten suchen, hat sich stets gewandelt. Suchmaschinen trugen dieser fortlaufenden Entwicklung Rechnung, indem sie immer auch vertikale Suchen und neue Komponenten in den Suchergebnisseiten integriert haben.

Jüngstes Beispiel ist die Google AI-Overview: Dort beantwortet Googles Large Language Model (LLM) Suchanfragen direkt in den Suchergebnissen, noch bevor überhaupt ein Klick auf einen Link möglich ist. Zunehmend verlagert sich die Informationssuche aber auch vollständig weg von klassischen Suchmaschinen – hin zu AI-Chatbots wie ChatGPT, Gemini oder Perplexity.

Nun ergeben sich mit jeder Evolutionsstufe von Webtechnologien und sich änderndem Nutzungsverhalten immer auch neue Herausforderungen für Webmaster und Agenturen, die wir uns in diesem Artikel mit Blick auf Generative AI einmal näher anschauen.

Wie ist der Status Quo von Generative Engine Optimization (GEO), welche Möglichkeiten bieten sich heute schon in der Analyse und Optimierung und welche Themen werden vielleicht größer gemacht, als sie sind.

Key Facts Generative-AI-Traffic & GEO

- Googles AI Overview und Chatbots wie ChatGPT oder Perplexity verschieben die Informationssuche zunehmend weg von klassischen Suchmaschinen. Antworten erscheinen direkt in den Suchergebnisseiten oder im Chat, oft ohne Klick auf einen Link.

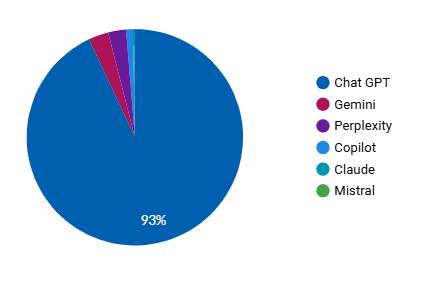

- Generative-AI-Traffic wächst rasant. Dabei dominiert ChatGPT den Markt und macht unseren Beobachtungen zufolge über 90 % des Generative-AI-Traffics einer Website aus.

- Erfolg wird nicht mehr nur an Rankings und Klicks gemessen, sondern an Sichtbarkeit, Zitationshäufigkeit, Sentiment und Kontext der Markenerwähnungen in LLMs.

- Nur ein geringer Teil der Chatbot-Antworten enthält überhaupt Links (z. B. ChatGPT: ~6 %).

- Tools wie Google Analytics liefern in wenigen Handgriffen wertvolle Hinweise auf das Nutzungsverhalten von Generative-AI-Traffic. Spezielle AI-Analyse-Tools hingegen zeigen relevante Insights wie Prompts, in denen die Marke erwähnt wird sowie fehlende Erwähnungen (Prompt Gaps), Sentiment, Zitationsrate, Share of Voice und weitere erfolgskritische Metriken.

- Chancen: Es gibt klare Optimierungsansätze, die Webmaster schon heute umsetzen können.

Grundlagen: SEO vs. GEO

Das Ziel von Suchmaschinenoptimierung (SEO) ist es, organischen Traffic über Suchmaschinen zu generieren, indem eine Website möglichst viele gute Rankings erzeugen kann.

Das Ziel von GEO hingegen ist es, dass die eigenen Inhalte von Chatbots in Antworten zitiert (und bestenfalls verlinkt) werden, indem sie von LLMs interpretiert und als relevante Information in Betracht gezogen werden.

Beide Disziplinen eint, dass der eigene Content eine Verbindung zu Nutzerinnen und Nutzern herstellt. Sichtbarkeit entsteht jedoch nicht mehr nur über Rankings und Klicks, sondern zunehmend auch dort, wo Menschen Antworten direkt von Chatbots oder AI-Overviews erhalten – oft ohne überhaupt noch eine Website zu besuchen.

Dabei erkennen wir schon heute Zusammenhänge zwischen Content, der in Suchmaschinen gut funktioniert und Content, der in Chatbots gut funktioniert.

Funktionsweise von Chatbots

Ein Large Language Model (LLM) ist in seiner einfachsten Form ein Programm, das den nächsten passenden Begriff in einem Text vorhersagt. Trainiert auf riesige Mengen an Text erkennt es Sprachmuster und kann so ganze Sätze oder Antworten formulieren.

Die heutigen Chatbots gehen allerdings weit über diese Grundfunktion hinaus. Sie bestehen zwar im Kern immer noch aus einem LLM, sind aber zu größeren Anwendungen ausgebaut, die zusätzliche Funktionen enthalten. Dazu gehört zum Beispiel eine Ad-hoc-Websuche: Wird eine Frage eingegeben, sucht der Chatbot passende Informationen im Internet und speist diese in das Sprachmodell ein. Auf diese Weise entstehen Antworten, die nicht nur sprachlich flüssig sind, sondern auch auf aktuelle Fakten zurückgreifen. Dieses Vorgehen ähnelt dem Prinzip der sogenannten „RAG-Architektur“ (Retrieval-Augmented Generation), bei der ein Sprachmodell durch externe Informationsquellen gezielt ergänzt wird.

Die großen Anbieter wie ChatGPT, Microsoft Copilot oder Google Gemini funktionieren im weitesten Sinne nach diesem Prinzip.

Aus Nutzungssicht spielt Googles AI Overview hier eine Sonderolle, da es eher als Ergänzung der Suchergebnissen auftritt und nicht als eigenständiger Chatbot; AI Overview wird als Answer Box in die Suchergebnisseiten integriert und automatisch ausgespielt, wenn es die Suchphrase in der klassischen Google-Sucheingabe erfordert. Die Mechanik dahinter ist indes die gleiche.

Eine Studie von Ahrefs/AiFunnel kam zu dem Ergebnis, dass Googles AI Overview im Wesentlichen oft eine Reproduktion der Suchergebnisse ist – in rund 76 % der Fälle waren die zitierten Seiten in der Overview auch auf Seite 1 der Suchergebnisse zu finden. Die Quote liegt bei klassischen Chatbots übrigens deutlich niedriger (z. B. ChatGPT: 8 %).

In jedem Fall stellen Large Language Models in ihren unterschiedlichen Erscheinungsformen aber eine neue Entwicklungsstufe dar, in der Frage, wie Menschen nach Informationen suchen und vor allem: wie Webmaster und Agenturen damit umgehen.

Generative AI: Status Quo

Bevor wir zu konkreten Handlungsempfehlungen kommen, wollen wir einen Blick auf das große Ganze werfen, um zu verstehen, welche Herausforderungen sich durch die neuen Technologien für Webmaster auftun.

Ein bedeutender Unterschied zwischen den Disziplinen SEO und GEO ist, dass es nicht mehr der Klick auf die eigene Website ist, die im Fokus aller Bemühungen des Webmasters steht, sondern die Sichtbarkeit der eigenen Marke.

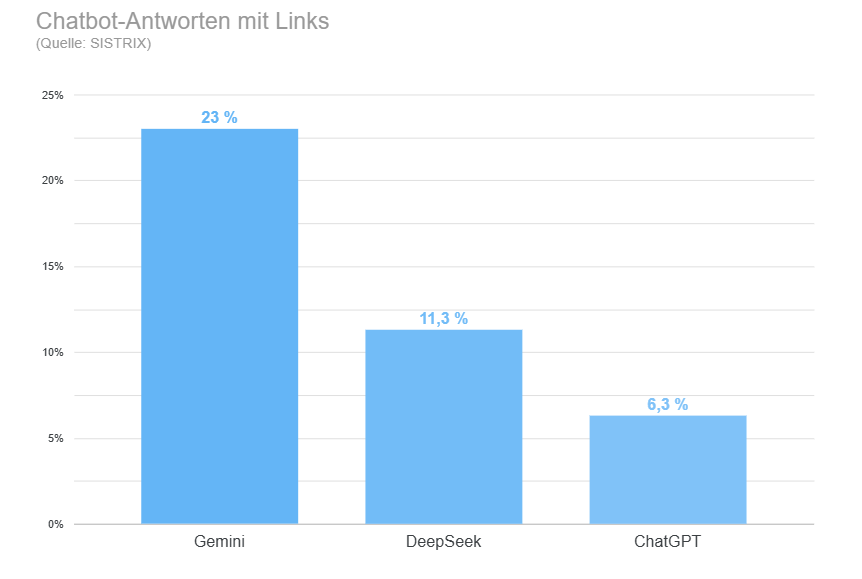

Jüngst hat SISTRIX herausgefunden, dass nur wenige Antworten, die ein Chatbot liefert auch tatsächlich Links enthält – also überhaupt erst den Absprung auf externe Webangebote ermöglicht.

ChatGPT, der Marktführer unter den LLMs, lieferte in dieser Studie sogar nur in rund 6 % aller Antworten einen Link. DeepSeek in rund 11 % der Fälle. Googles Gemini hingegen 23 %.

Daraus ließe sich nun schnell ableiten, dass jede GEO-Bemühung aus Sicht des Website-Betreibers nur limitierten Erfolg verspricht, da das Potential, Traffic zu generieren, systemimmanent begrenzt zu sein scheint – doch das wäre zu kurz gegriffen. Denn dieser Trend hat nicht erst mit der Erscheinung von Chatbots und AI-Overviews begonnen – seit Jahren bauen Google und andere „Gatekeeper“ daran, die Bedürfnisse der Zielgruppen innerhalb der eigenen Plattform zu bedienen. SparkToro schrieb 2024, dass rund 60 % der Suchanfragen in den USA und Europa bereits ohne einen externen Linkklick enden.

Trotz allem macht die organische Suche im Regelfall auch heute noch einen Großteil des Traffics einer Website aus.

Generative AI ist zu jung, um das Thema nur aus der Perspektive der potentiellen Trafficakquisition zu beleuchten – im Gegenteil; wer heute für Sichtbarkeit in LLMs sorgt, gewinnt morgen an Relevanz.

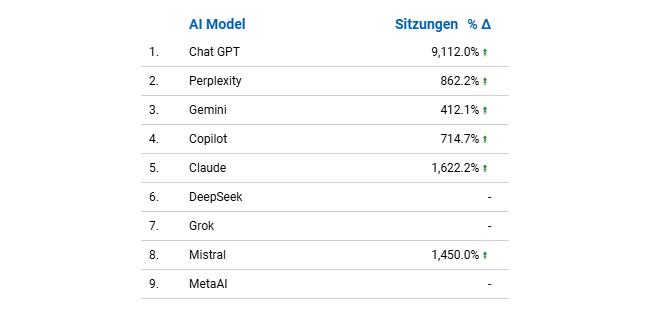

Denn was vermutlich alle Websitebetreiber in den vergangenen Monaten feststellen, ist, dass der Traffic, der von Chatbots auf die eigene Website kommt rapide wächst. Year-to-date sehen wir bei vielen Projekten häufig Wachstumsraten von mehreren Tausend Prozent.

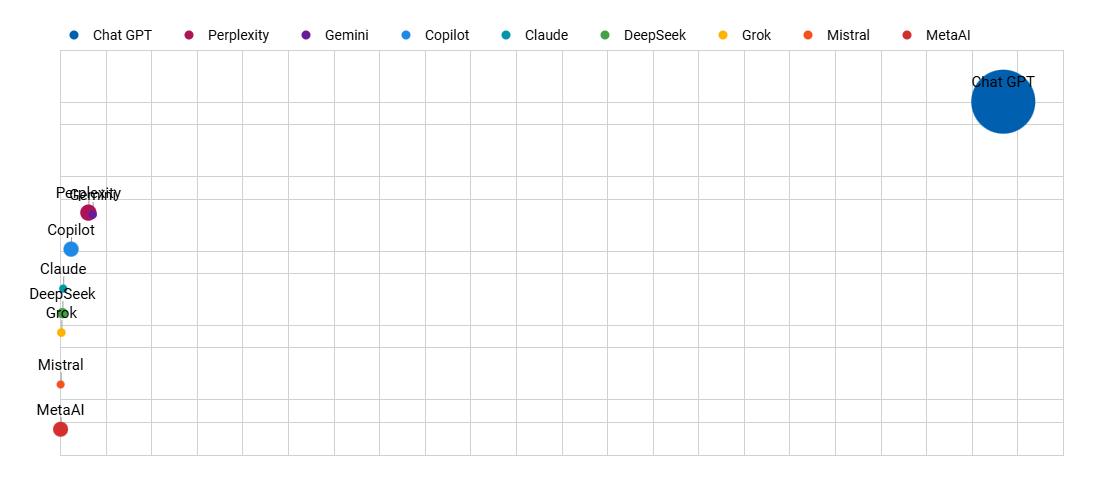

Projektübergreifend stellen wir fest, dass ChatGPT – mit großem Abstand zu seinen Wettbewerbern – in einer dominanten Markstellung ist und in der Regel über 90 % des Generative-AI-Traffics ausmacht (links).

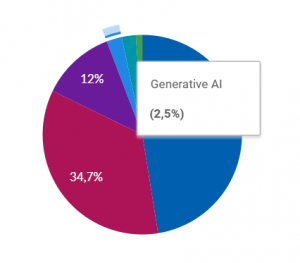

Im Gesamtkanalmix machen LLMs (nach unseren Beobachtungen – je nach Größe und Reputation der Brand/Website – zwischen 1 % und 5 % aus (rechts).

Und hier gilt: Je sichtbarer eine Domain in den Google-Suchergebnissen ist, desto mehr Generative-AI-Traffic generiert sie.

Betrachtet man nur die Referer, ist der Kanal Generative-AI-Traffic zusammengenommen allerdings fast immer auf den vorderen Plätzen der Top-10.

Analyse von Generative AI Traffic

Wir haben nun zwei Ebenen, auf denen wir das Thema analysieren können. Zum einen werfen wir einen Blick auf Quantität und Qualität des OnPage-Traffics, der von Chatbots kommt und zum anderen wollen wir einen Blick in den Maschinenraum erhaschen, um zu verstehen, wie Chatbots mit den eigenen Inhalten interagieren.

Onpage-Analyse

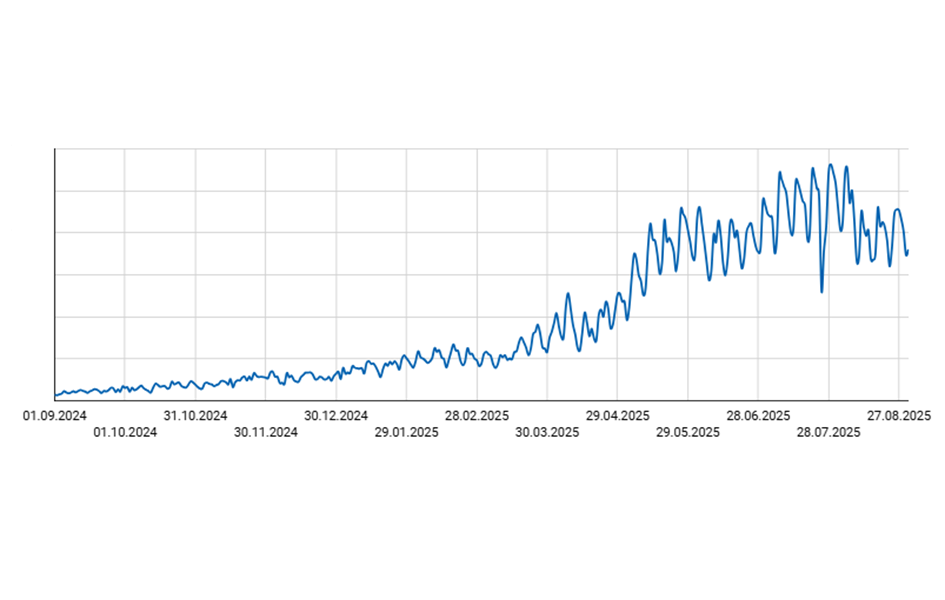

Das Potenzial von Generative-AI-Traffic beginnt mit einer Beschreibung der OnPage-Traffic-Daten. Mithilfe von Google Analytics oder anderen Analysetools können Webmaster bereits sehr fein aufzeigen, wie viel Traffic von welchen Modellen kommt und wie er sich auf der Website verhält.

Spannend sind hier vor allem die Unterschiede zu anderen Kanälen – also bspw. die Frage nach Unterschieden auf den Einstiegsseiten? Oder zu welchem Grad Nutzerinnen und Nutzer aus LLMs die gewünschten Aktionen auf der Website ausführen? Wie sehen die Nutzungspfade innerhalb der eigenen Website aus? Sind andere Suchintentionen in LLMs zu erkennen als bspw. in der organischen Suche?

Auf dieser Basis lassen sich Strategien entwickeln, die Inhalte gezielt für KI-Systeme aufzubereiten, Sichtbarkeit in AI-Overviews und Chatbots zu erhöhen und letztlich den Traffic qualitativ wie quantitativ besser nutzbar zu machen.

Tools zur Chatbot-Analyse

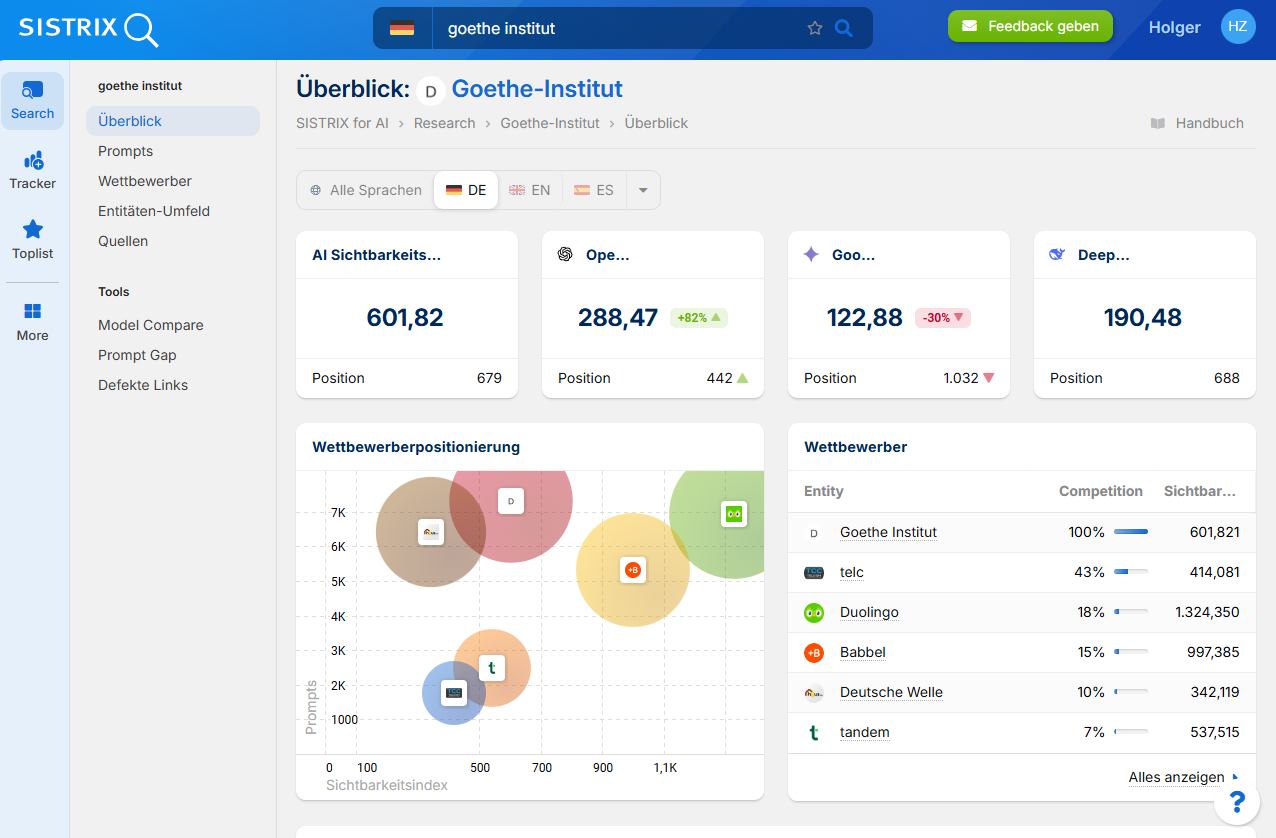

Doch wichtiger ist die Frage, wie Chatbots mit den eigenen Inhalten umgehen oder besser gesagt: mit der eigenen Marke?

Mit externen AI-Analysetools wie SISTRIX lassen sich die Datenpunkte untersuchen, die aus der Interaktion mit Chatbots entstehen. Für Marken wird dadurch sichtbar, mit welchen Prompts Menschen in Systemen wie ChatGPT, Perplexity oder Gemini arbeiten, in welchem Kontext und Stimmungsumfeld die eigene Marke auftaucht und wie diese Antworten ausgestaltet sind.

Klassische Werkzeuge wie Google Analytics oder Referrer-Analysen helfen zwar dabei, Muster zu erkennen – etwa welche Landingpages plötzlich Zugriffe aus Chatbot-Umgebungen erhalten –, an die tatsächlichen Prompts, die zu Markenerwähnungen führen, gelangt man damit jedoch nicht.

Genau hier setzt das sogenannte Prompt Mapping an: Es macht transparent, welche Anfragen die eigene Marke in KI-Antworten hervorbringen – und wo nicht. Diese Prompt Gaps liefern wertvolle Hinweise, wie Inhalte gezielt erweitert oder optimiert werden können.

SISTRIX Toolbox zur Analyse von Chatbots und LLMs

Über die reine Sichtbarkeit hinaus kommen im GEO-Bereich weitere Metriken ins Spiel: Sentiment-Analysen, die zeigen, in welchem Stimmungsumfeld eine Marke genannt wird; die Zitationshäufigkeit, also das Verhältnis der eigenen Nennungen zur Gesamtzahl relevanter Prompts; der Wettbewerbsvergleich mit Kennzahlen wie Share of Voice oder Prompt Overlap; sowie die Kohärenz der Prompts, also die Frage, ob der eigene Content wirklich zu den Suchintentionen passt, in denen die Marke erscheint.

Die Leistung in Googles AI-Overview hingegen lässt sich im wesentlichen noch über die klassischen SEO-Tools auswerten, da sie als organischer Treffer (vertikale Suche) ausgewertet werden kann.

Mit diesen Informationen können sehr gezielt Maßnahmen ergriffen werden, die die Sichtbarkeit in Chatbots erhöht.

Fazit & Handlungsempfehlungen

Um in einer Welt von Null-Klick-Suchen und KI-generierten Antworten sichtbar zu bleiben, sollte eine Website in mehreren Dimensionen strategisch aufgestellt sein:

GEO-Basics berücksichtigen

Inhalte müssen so gestaltet sein, dass KI-Systeme sie leicht erkennen, interpretieren und weiterverwenden können. Dazu gehört eine textlich saubere Strukturierung, aber auch z. B. durch die Verwendung des Schema.org-Markups; semantisch korrekte HTML-Auszeichnungen sowie eine klare und leicht extrahierbare Formatierung.

Markenbekanntheit & Autorität stärken

Da immer mehr Suchanfragen ohne Klick beantwortet werden, ist es entscheidend, dass die eigene Marke auch ohne direkten Website-Besuch sichtbar ist. Vertrauen und Autorität entstehen unter anderem durch konsequente Umsetzung der E-E-A-T-Prinzipien (Experience, Expertise, Authoritativeness, Trustworthiness), die wir ja auch aus der Suchmaschinenoptimierung kennen – etwa durch transparente Autorenangaben, belastbare Quellen und eine klare Markenpositionierung zu bestimmten Themenkomplexen. Eine hohe organische Sichtbarkeit in Suchmaschinen ist hier bereits ein guter Indikator, der sich vermutlich in eine hohe Sichtbarkeit in den LLMs übersetzt.

Content-Distribution diversifizieren

Inhalte sollten nicht nur auf der eigenen Website erscheinen, sondern auch auf externen Plattformen. Diese Verbreitung erhöht zum einen die Chance, dass Chatbots die Marke in Antworten aufnehmen, da sie als Multiplikator dienen, erweitert aber gleichzeitig die Unabhängigkeit von und die Reichweite jenseits von Google & Co..

SEO konsequent weiterführen

Klassisches SEO bleibt das Fundament: Eine saubere technische Basis, hochwertige Inhalte und eine starke Linkstruktur sorgen weiterhin für organische Sichtbarkeit. Und GEO baut auf diesen Grundlagen auf. Wir sehen einen klaren Zusammenhang zwischen Organischer Sichtbarkeit und der Menge von Generative-AI-Traffic, da die klassischen Suchergebnisse immer noch eine wichtige Komponente von LLMs darstellen. Nicht zuletzt haben wir bereits gelernt, dass Googles AI-Overview in großen Teilen „nur“ die Suchergebnisse repliziert.

Neue Analysemöglichkeiten nutzen

Aggregierte Daten wie in diesem Artikel sind hilfreich, ersetzen jedoch nicht die eigene Evaluation. Webmaster sollten eigene Dashboards entwickeln, Nutzungsverhalten im Detail analysieren und externe Tools oder Agenturen nutzen, die KI-Sichtbarkeit messen können. Nur so lassen sich datengetriebene Handlungsempfehlungen ableiten, die auf die individuelle Situation zugeschnitten sind.